Aunque el uso de inteligencia artificial (IA) está aumentando en todo el espectro de la automatización industrial, muchos en la industria aún no tienen claro su aplicación y sus beneficios. Esto no es sorprendente teniendo en cuenta que las aplicaciones de IA no son algo con lo que la mayoría de los usuarios finales interactuarán directamente de forma consciente. La IA tiende a trabajar detrás de escena, procesando entradas y acciones para optimizar las funciones de los sistemas que la emplean.

Max Versace, CEO y cofundador de Neurala

Max Versace, CEO y cofundador de Neurala

Hace unos meses, Automation World se conectó con Anatoli Gorchet, cofundador y director de tecnología de Neurala (un proveedor de software de visión de IA), para comprender mejor cómo funciona la inteligencia artificial (IA) en los procesos de inspección industrial utilizando visión artificial. Tras la publicación de las ideas de Gorchet, nos enteramos de otro término de IA con el que no estábamos familiarizados: explicabilidad.

Este término se refiere a la IA explicable, un conjunto de técnicas (incluido el código de software y la interfaz de usuario) que crea una ruta legible por humanos desde un dato determinado hasta una decisión específica. "En esencia, estas técnicas embotellan esa comprensión intuitiva que un estudiante de doctorado en IA desarrolla, en un proceso inteligible y replicable que se puede entregar al usuario final", dijo Max Versace, director ejecutivo y cofundador de Neurala.

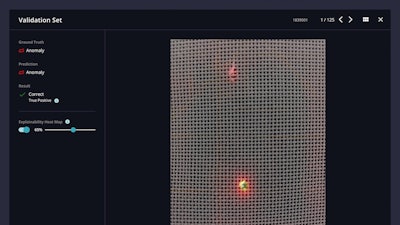

Según Versace, la explicabilidad es “fundamental para la depuración. No importa cuán explicable resulte la IA, nadie implementará una solución que cometa toneladas de errores. Debe poder ver cuándo falla la IA y por qué falla. Y las técnicas de inteligencia artificial explicables pueden ayudarlo a determinar si la inteligencia artificial se está enfocando en las cosas incorrectas".

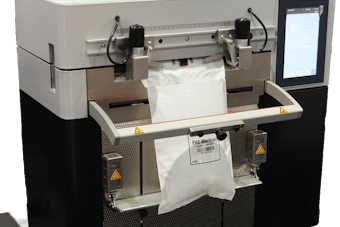

Como ejemplo, Versace dijo considerar una red de aprendizaje profundo implementada en cámaras industriales para proporcionar garantía de calidad en un entorno de fabricación. “Esta IA podría ser engañada para clasificar algunos productos como normales cuando, de hecho, son defectuosos. Sin saber en qué parte de la imagen se basa el sistema de IA para decidir 'buen producto' frente a 'mal producto', un operador de máquina podría sesgar involuntariamente el sistema ", dijo. “Si muestran constantemente el 'producto bueno' en un fondo rojo y el 'producto malo' en uno amarillo, la IA clasificará cualquier cosa sobre un fondo amarillo como un 'producto malo'. Sin embargo, un sistema de IA explicable comunicaría inmediatamente al operador que está utilizando el fondo amarillo como la característica más indicativa de un defecto. El operador podría usar esta información para ajustar la configuración de modo que ambos objetos aparezcan en un fondo similar. Esto da como resultado una mejor IA y la prevención de un despliegue de IA posiblemente desastroso".

Más allá de este tipo de aplicación, la explicabilidad también permite la responsabilidad y la auditabilidad, dijo Versace. Puede ayudar a responder quién diseñó el sistema y cómo fue construido y preparado.

“Al final del día, los humanos están transfiriendo decisiones clave a la IA”, dijo Versace. “Y cuando se trata de evaluar la confianza, adoptan un enfoque similar al de evaluar si confiar o no en un compañero de trabajo humano. Los seres humanos desarrollan confianza en sus compañeros de trabajo cuando se cumplen al menos dos condiciones: su desempeño es fantástico y pueden articular de manera inteligible cómo obtuvieron ese resultado. Para la IA, la misma combinación de precisión e inteligibilidad allanará el camino para una adopción más amplia".